100Gbit síťové karty

FAQ: 100Gbit síťové karty

100Gbit síťové karty

Uvádíme na trh 100Gbitové síťové karty (1/2023). Tímto jsou komponenty pro budování 100Gbitových sítí v naší nabídce kompletní:

Síťové karty 100Gbit

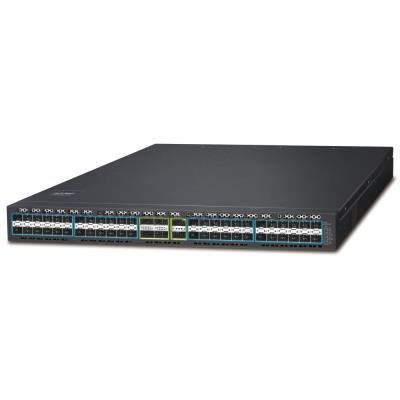

Přepínače 100Gbit

Optické moduly QSFP28

Optické kabely MTP/MPO (zvláště atraktivní ve spojeni s moduly 100G-SR4)

Uvedení na trh dostupných 100Gbitových Ethernetových karet dovoluje budování extra výkonných systému. A to bez použití speciálního hardwaru dostupného jen u několika značek. Návazná propojovací struktura využívá standardního Ethernet vybavení a dovoluje tak extrémně zvýšit efektivitu systémů.

Přenosová rychlost 100Gbit/s znamená v jednom směru přenos cca. 10GB/s. A to je komunikace plně obousměrná tedy v úhrnu 20GB/s.

Pokud si provedeme srovnání s dnešními datovými prostředky tak jde o přenosovou kapacitu do níž se vejde

• simultánní zápis na 100 moderních HDD (za předpokladu jejich rychlosti 0,1GB/s).

• simultánní zápis na 20 SSD (za předpokladu jejich rychlosti 0,5GB/s).

• simultánní zápis na 2x NVMe M.2 (za předpokladu jejich rychlosti 5GB/s).

Technická náročnost zprovoznění 100Gbitových sítí se významně neliší od propojování 10Gbitových sítí. Z hlediska výběru komponent nastává variabilita jen v případě, že je třeba propojovat trasy pro vzdálenosti nad 100m, kde je k dispozici výběr QSFP28 modulů s různými optickými technologiemi dovolujícími spojení do 20km.

Pro vytváření sítí v rámci budovy či jen rozvaděče sáhnete po modulech typu 100G-SR4.

Čím se musíte zabývat aby pro vás 100Gbit síťová karta v serveru měla smysl

- distribuovanými výpočty: nízká latence je zásadní pro všechny takové systémy

- virtualizací serverů: cloudová řešení, bez vysokorychlostních propojení to nejde, technologie RDMA pak "odpracují" většinu za vás

- virtualizací a centralizací úložišť: vysokorychlostní síťové rozhraní je generačně nezbytnost pro moderní, kapacitní a ekonomický SAN

RDMA

Správce systémů okamžitě napadne, že pro využití takovéto kapacity by musel být jejich server vybaven extra výkonným procesorem což samozřejmě vyvolává pochyby o jejich aplikovatelnosti a využitelnosti.

A o tom je právě využívání technologie RDMA, která je zabudována ve vlastním procesoru 100Gbit síťové karty od Intelu. RDMA je podobný posun jako bylo zavedení DMA v počítačích. Tj. přenos data z a do paměti bez účasti CPU.

RDMA je zkratka pro "Remote Direct Memory Access" přes Ethernetovou síť. Je tak možné propojit počítače pomocí 100Gbit datové sítě tak jakoby šlo o jeden počítačový systém který si sdílí svá vysokorychlostní paměťová úložiště a to bez újmy na výkonu CPU.

Typickou aplikací 100Gbit síťových karet se tak stává virtualizace datových úložišť a virtualizace serverů. Ve skutečnosti ale má našlápnuto i k náhradě nejrůznějších technologií pro distribuované výpočty, jelikož sleduje úplně stejně jako propustnost také minimalizaci latence.

Uváděné řady síťových karet s čipovou sadou Intel E810 zavádějí defakto i nový standard funkcí které budeme nadále v 100Gbitových síťových kartách očekávat a tím je vestavěný akcelerátor pro RDMA technologie iWARP a RoCEv2.

NVMe over Fabrics (NVMe-oF)

Nevyhnutelně jste se setkali již se zkratkou NVMe v souvislosti s SSD disky. Víte, že pokud přijde řeč na NVMe obvykle se zmiňuje současně i typ M2 rozhraní a rychlost sběrnice PCIe.

Ale NVMe je daleko univerzálnější standard rozhraní a v souvislosti se 100Gbit síťovým rozhraním se budete setkávat s dalšími typy NVMe:

NVMe PCIe = znáte z použití svých SSD disků s rozhraním M.2, tj. aplikujete jej v rámci PCIe sběrnice svého počítače.

NVMe RDMA = vyžaduje síťový adaptér který umí využívat některou z technologií pro přímý přístup k paměti. Typicky vynechává z komunikace CPU a tedy není na něm výkonnostně závislé. Technologie které se uplatňují: RoCE, iWARP, InfiniBand, OPA

NVMe/TCP = univerzálnější, méně závislá na hardwaru. Je ale závislá na výkonu jádra CPU serveru. Typicky je pomalejší než NVMe RDMA. Je chápána jako přímá náhrada za iSCSI a je široce podporována ve všech hlavních Linux distribucích

A právě nová řada Intel E800 síťových karet je vybavena nejen již výše zmíněnou akcelerací RDMA technologie (iWARP a RoCEv2) ale také akcelerací pro NVMe/TCP s podporou ADQ (Application Device Queues). Ty dle tvrzení Intelu dokonce dovolí docílit lepší propustnosti než při užití NVMe RDMA.

Poznámky k termínům:

iWARP (Internet Wide-area RDMA Protocol)

implementace RDMA nad protokolem TCP/IP, je dlouhodobě podporována v serverech Windows, její výhodou je schopnost využívat RDMA pro spojení WAN a její spolehlivost je vestavěna v TCP protokolu.

RoCE (v1)

RDMA over Converged Ethernet (RoCE), můžete také znát jako InfiniBand over Ethernet (IBoE). Implementace RoCE v1 využívá Ethernet layer. Není používáno ve zmiňovaných produktech.

Přehledně popsáno na Wikipedia: https://en.wikipedia.org/wiki/RDMA_over_Converged_Ethernet

RoCE v2

RDMA používající vrstvu UDP/IPv4 nebo UDP/IPv6. Typicky je tak její aplikace omezena na oblast sítě v níž máme naprostou kontrolu nad řízením UDP protokolu.